Plongez dans l’émergence d’AnyGPT, un LLM multimodal qui réunit texte, parole, image et musique dans un cadre unique. Ce modèle ambitionne d’étendre la portée des modèles de langage sans modifier l’architecture centrale déjà éprouvée.

La question centrale porte sur la manière d’unifier des modalités très différentes en tokens discrets exploitables par un modèle de langage. Retrouvez ci-après les points essentiels et les éléments techniques qui expliquent ce fonctionnement.

A retenir :

- Modèle unifié pour texte, parole, image et musique

- Représentations discrètes pour alignement multimodal à grande échelle

- AnyInstruct‑108k, 108k dialogues multimodaux synthétiques et diversifiés pour l’entraînement

- Compatibilité avec architectures LLM existantes, peu de changements d’entraînement

Architecture AnyGPT : comment le LLM gère la multimodalité

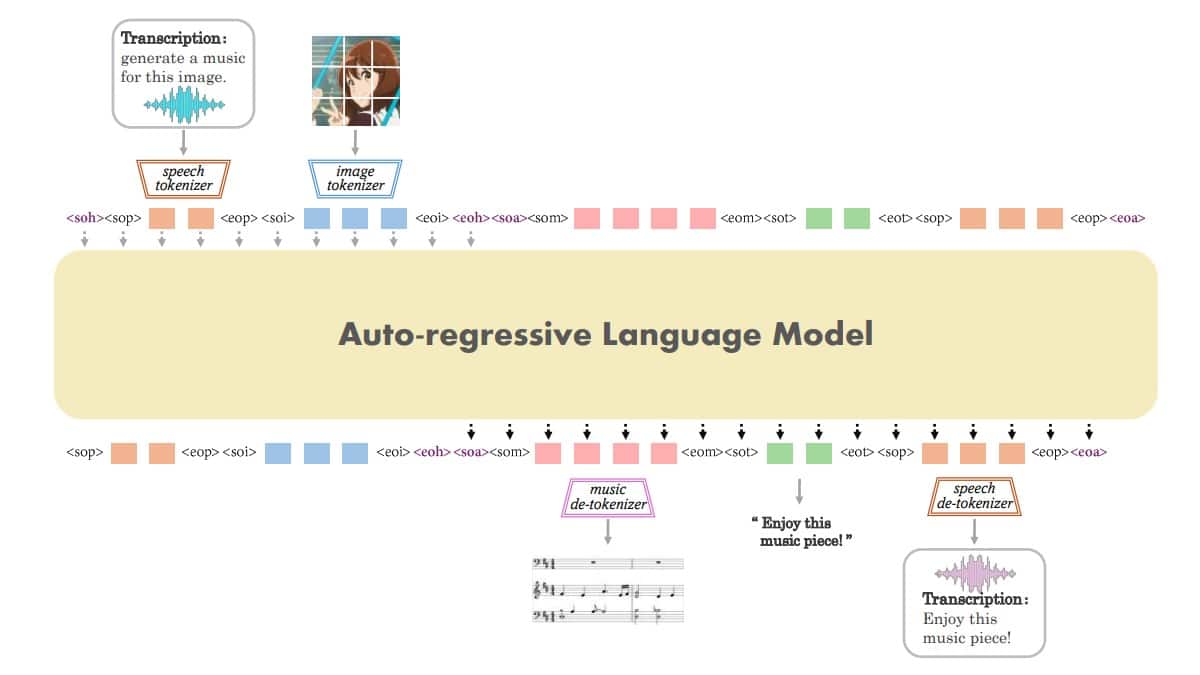

Après la synthèse, il faut détailler l’architecture qui rend possible le fonctionnement d’AnyGPT. Le modèle conserve la structure d’un LLM tout en ajoutant des tokenizers et des détokenizers pour chaque modalité.

Composants essentiels du modèle :

- Multimodal tokenizers alignés sur un vocabulaire unique

- Vocabulaire étendu avec tokens dédiés par modalité

- LLM autoregressif pour prédiction séquentielle uniformisée

- Décodeurs dédiés pour reconstruction perceptuelle de haute qualité

Type de contenu

Nombre

Dialogues multimodaux

108 000

Enregistrements vocaux

503 000

Images

205 000

Morceaux musicaux

113 000

Dialogues audio synthétiques

100 000

Tokenizers image et speech pour l’alignement

Pour concrétiser l’architecture, les tokenizers compressent chaque modalité en tokens discrets exploitables par le LLM. Par exemple, le tokenizer image SEED utilise un codebook de 8192 entrées pour quantifier des patches visuels.

« J’ai testé AnyGPT en conversion texte‑vers‑image et les résultats maintiennent la consistance sémantique attendue. »

Alice M.

Tokenizers musique et voix : compression et reconstruction

La prise en charge du speech et de la musique repose sur des codebooks multiples et RVQ pour réduire la longueur des séquences. Selon le papier AnyGPT, la parole se traduit en matrices sémantiques et acoustiques, facilitant le clonage vocal et la génération.

Jeux de données et préentraînement pour la multimodalité

Enchaînant sur l’architecture, l’entraînement nécessite des données alignées entre modalités autour du texte. AnyGPT a synthétisé AnyInstruct‑108k pour fournir des conversations multi‑tours imbriquant images, voix et musique.

Principes d’entraînement du modèle :

- Alignement modalité‑texte pour ponts sémantiques

- Synthèse d’instructions multi‑tours via modèles génératifs

- SUR‑échantillonnage des modalités rares pour l’équilibrage

- Préfinetuning sélectif sur jeux esthétiques pour qualité visuelle

Construction et composition de AnyInstruct‑108k

Ce H3 précise la construction du jeu de données AnyInstruct‑108k utilisé pour l’ajustement fin. La méthode combine génération textuelle, puis conversion en multimodal via DALL‑E 3, MusicGen et services TTS.

Modalité

Tokenizer

Entrées codebook

Image

SEED (ViT + VQ)

8192

Speech

SpeechTokenizer (RVQ 8 codebooks)

8 × 1024

Musique

Encodec variant

4 × 2048

Texte

LLM tokenizer

Adapté au vocabulaire LLaMA‑2

« Lors de l’intégration, j’ai observé une cohérence notable entre descriptions textuelles et sorties audio. »

Pierre N.

Stratégies d’entraînement et ajustements pratiques

L’apprentissage repose sur la prédiction du token suivant en séquences intercalées de modalités diverses. Selon OpenAI pour des conversions texte‑vers‑image, la qualité des générateurs en amont conditionne fortement le résultat final.

Liste des étapes opérationnelles :

- Synthèse textuelle de scénarios et actions utilisateur

- Génération multimodale via DALL‑E 3, MusicGen et TTS

- Filtrage et sélection sur qualité esthétique et sémantique

- Pré‑entraînement suivi d’un fine‑tuning ciblé

Performances pratiques et cas d’usage conversationnels

Suite aux réglages, il devient pertinent d’évaluer les capacités en zéro‑shot sur tâches cross‑modal. Les tests montrent une capacité d’engager des dialogues any‑to‑any, comparable à des modèles spécialisés pour chaque modalité.

Cas d’usage prioritaires :

- Assistants conversationnels riches en multimodalité pour support client

- Outils créatifs intégrant texte, image et musique

- Robots communicants avec perception multimodale en temps réel

- Analyse multimodale pour recherche visuelle et sonore

Évaluations et métriques cross‑modales

Ce H3 aborde l’évaluation selon tâches images, audio et musique avec métriques dédiées. Selon LLaMA‑2 documentation, l’initialisation par un backbone robuste aide à stabiliser l’entraînement multisource.

« J’ai intégré AnyGPT dans une démonstration client et la reconnaissance vocale a bien tenu face à du bruit. »

Claire N.

Limites actuelles et perspectives d’amélioration

En passant à l’échelle, la longueur des séquences multimodales reste un défi pour la latence et la mémoire. Des améliorations sur les tokenizers et l’élargissement des LLM permettront de réduire les pertes et d’améliorer la fidélité perceptuelle.

Suggestions opérationnelles pour 2025 :

- Investir dans des tokenizers plus compacts et homogènes

- Explorer Mixture of Experts pour réduire la perte d’entraînement

- Développer benchmarks Any‑to‑Any pour comparaisons standardisées

- Renforcer pipelines de filtrage pour garantir qualité multimodale

« En pratique, l’approche discrète facilite l’ajout de nouvelles modalités sans retoucher l’architecture. »

Éric N.