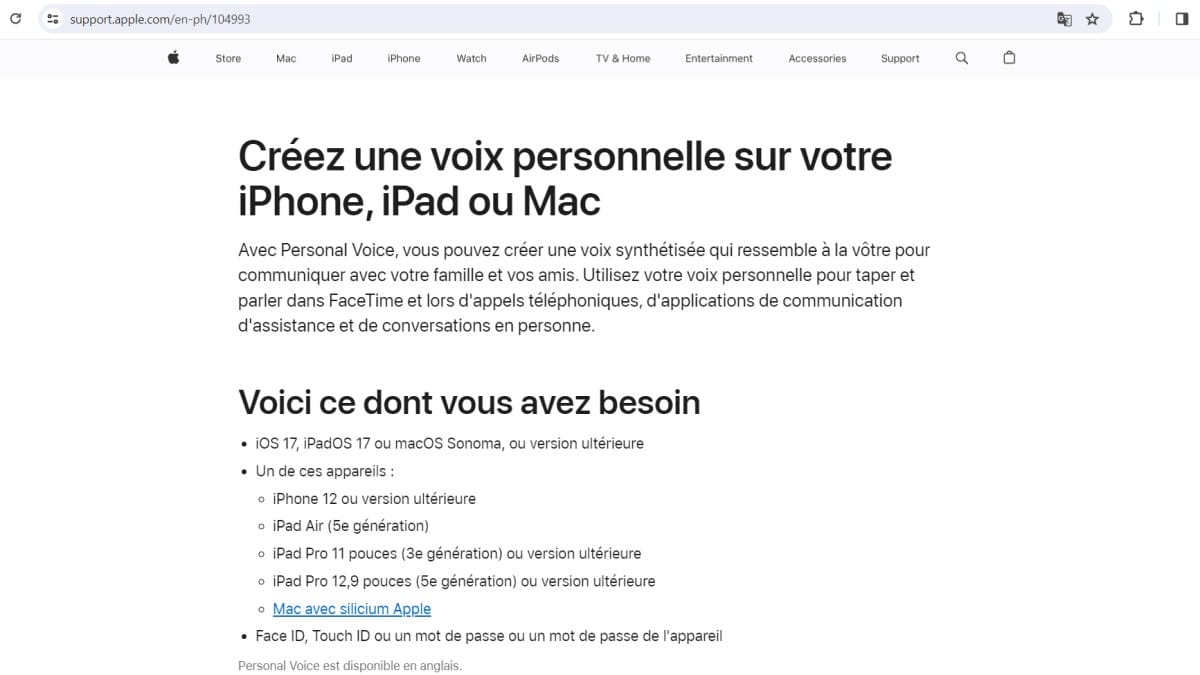

Apple a introduit Personal Voice dans iOS 17 pour reproduire la voix des utilisateurs en format numérique apparenté. Cette fonctionnalité vise à préserver la communication des personnes confrontées à des troubles de la parole et à offrir une voix familière.

Personal Voice combine des enregistrements vocaux guidés et de l’apprentissage automatique exécuté localement sur l’appareil pour protéger les données. Pour guider la lecture, voici les points essentiels à garder en tête.

A retenir :

- Création d’un modèle vocal à partir de quinze minutes d’enregistrements audio

- Traitement sur l’appareil pour protection des données personnelles

- Utilisation avec Live Speech pour appels FaceTime et conversations téléphoniques

- Compatibilité iPhone iPad et Mac avec synchronisation via iCloud optionnelle

Personal Voice : principe et création de la voix

Pour comprendre l’usage, il faut d’abord examiner le principe de création de la voix et ses étapes concrètes. Apple demande des enregistrements guidés, puis génère un modèle vocal grâce au Neural Engine intégré.

La génération du modèle repose sur un apprentissage automatique conçu pour rester local, ce qui renforce la confidentialité des enregistrements. Cette approche prépare naturellement l’examen des usages et des paramètres d’accès.

Étapes de création :

- Ouverture des paramètres Accessibilité sur iPhone ou iPad

- Sélection de la fonction Voix personnelle puis choix d’un nom

- Suivi des phrases guidées pour enregistrer quinze minutes de voix

- Attente de la génération locale pendant la charge nocturne

Étape

Description

Durée approximative

Confidentialité

Enregistrement

Enregistrement guidé de phrases sur l’appareil

15 minutes

Sur l’appareil

Vérification

Réécoute et réenregistrement possible avant validation

Variable selon l’utilisateur

Local

Traitement

Génération du modèle vocal par apprentissage automatique

Génération durant charge nocturne

Traitement local

Activation

Activation via Live Speech et réglages d’utilisation

Immédiaire après génération

Option iCloud

Suppression

Effacement du modèle et des enregistrements sur demande

Immédiat après confirmation

Effacement local

Enregistrement sur iPhone et durée requise

Cette étape d’enregistrement se déroule directement sur l’iPhone ou l’iPad compatibles, guidée par l’interface Accessibilité. L’opération demande environ quinze minutes de phrases lues, réparties en segments pour capturer les variations vocales.

« J’ai enregistré ma voix en une session guidée, le processus m’a semblé simple et rassurant. »

Marie N.

Traitement local et garanties de confidentialité

Le traitement du modèle se fait sur l’appareil, afin de limiter les transferts vers le cloud et protéger les données personnelles. Selon Apple, ce traitement local repose sur le Neural Engine et réduit le risque d’accès externe aux enregistrements.

Cette conception place la confidentialité au centre du dispositif, mais elle n’annule pas la nécessité d’un consentement explicite et d’une gestion des sauvegardes iCloud. Le passage technique suivant porte sur l’intégration dans les usages quotidiens.

« La possibilité de conserver ma voix numérique m’a donné l’assurance de pouvoir continuer à parler. »

Jean N.

Usage pratique : Live Speech, appels et intégrations

Après la génération du modèle vocal, la manière dont la voix est utilisée détermine son impact au quotidien. Live Speech permet de faire parler la voix créée lors d’appels, FaceTime et interactions en personne grâce à une synthèse immédiate.

Les réglages d’accès et la synchronisation éventuelle sur plusieurs appareils facilitent l’usage pour un proche ou un aidant chargé de la communication. La section suivante détaille la configuration pas à pas.

Paramètres et accès :

- Activation de Discours en direct dans Accessibilité

- Choix de la Voix personnelle dans le menu Voix

- Ajout de phrases préférées pour accès rapide

- Triple pression du bouton d’alimentation pour lancer Live Speech

Configurer Live Speech pour appels et FaceTime

La configuration commence par l’activation de Discours en direct et le choix du profil vocal personnalisé dans les réglages. Ensuite, il suffit d’ajouter des phrases préférées et de paramétrer l’accès rapide avec le bouton d’alimentation.

Selon The Verge, l’expérience se veut immédiate pour l’utilisateur et compatible avec les standards d’accessibilité, tout en laissant la gestion de la voix sous contrôle personnel. Une démonstration pratique illustre ces étapes en vidéo.

Cas d’usage quotidiens et intégrations applicatives

Les usages concrets vont des appels téléphoniques aux messages lus à voix haute, en passant par des interactions assistées avec des aidants. Les intégrations possibles comprennent les apps de communication alternative et des outils de santé accessibles.

Un fil conducteur simple aide à prioriser les cas d’usage : disponibilité immédiate pour conversation, sauvegarde pour situations progressives, et partage contrôlé sur plusieurs appareils. Selon MacRumors, la synchronisation iCloud reste optionnelle et soumise au consentement.

Écosystème, concurrence et enjeux éthiques

En élargissant le regard, la comparaison entre acteurs met en lumière des approches techniques et commerciales divergentes. Apple privilégie le traitement sur l’appareil, tandis que d’autres fournisseurs combinent options cloud et personnalisations proposées par tiers.

Cette diversité renvoie à des enjeux réglementaires et d’acceptation sociale, qui obligent à définir des bonnes pratiques pour le consentement et la protection des voix. Le tableau suivant résume les positions générales des acteurs principaux.

Acteurs et rôles :

Acteur

Approche

Personnalisation

Confidentialité

Usage typique

Apple

Traitement on-device et modèle personnel

Oui, modèle individuel

Forte priorité au local

Accessibilité et communication personnelle

Microsoft

Cloud et solutions d’entreprise

Personnalisation via services

Approche hybride

Solutions professionnelles et santé

Google

TTS cloud et API

Voix synthétiques variées

Contrôles en plateforme

Assistants et services web

Amazon

Cloud TTS pour développeurs

Personnalisation commerciale

Gestion via comptes

Alexa et intégrations IoT

Samsung

Solutions intégrées aux appareils

Voix système personnalisables

Configurations locales et cloud

Assistants mobiles

Acapela

Fournisseur de voix synthétiques

Voix sur mesure disponibles

Contrat avec clients

Applications professionnelles

Nuance

Historique en santé et entreprise

Personnalisation pour secteurs ciblés

Conformité réglementaire

Centres d’appels et santé

Voxygen

Voix synthétiques et clonage vocal

Personnalisation avancée

Contrôle client

Médias et assistive tech

VocaliD

Voix personnalisées pour individus

Forte personnalisation

Modèles protégés

Voix pour personnes privées de parole

Comparaison des acteurs et de leurs approches

Comparer ces acteurs montre des compromis entre personnalisation et mode de traitement des données, ainsi que des modèles économiques distincts. Les choix techniques influent directement sur la confidentialité et l’adoption par les professionnels de santé.

Risques, consentement et bonnes pratiques

Les risques identifiés concernent l’usage non autorisé d’une voix synthétique et la durabilité du consentement pour des voix sensibles. Les bonnes pratiques recommandées incluent un consentement explicite, un contrôle d’accès et des procédures d’effacement claires.

- Consentement explicite et documenté pour création vocale

- Accès restreint aux modèles et journalisation des usages

- Procédure d’effacement simple et vérifiable

- Éducation des proches et des aidants aux risques

« Savoir que ma mère conservera sa voix synthétique m’a profondément touché. »

Paul N.

« La technologie pose des questions juridiques et morales à résoudre rapidement. »

Clara N.